AIをブラックボックスにしないために、“判断の根拠”の解析を:自動運転技術

日立超LSIシステムズ 組込ソリューション事業部の猪貝 光祥氏が、NVIDIAのユーザーイベント「GTC Japan 2018」(2018年9月13〜14日)において、AIの品質保証に関する最新動向を紹介した。

人工知能(AI)はなぜその結論に至ったのか――。日立超LSIシステムズ 組込ソリューション事業部の猪貝 光祥氏が、NVIDIAのユーザーイベント「GTC Japan 2018」(2018年9月13〜14日)において、AIの品質保証に関する最新動向を紹介した。

自動運転技術の開発では、自車の周辺にある物体の種類の識別や走行可能なエリアの検出といった周辺環境の認識などにおいて、深層学習(ディープラーニング)で得たアルゴリズムの活用が進む。Robert Bosch(ボッシュ)は2019年にディープラーニングなどのアルゴリズムで周辺環境を認識する次世代ステレオカメラの量産を予定するなど、市販モデルの運転支援システムにもディープラーニングの技術が浸透するのが見えてきた。

しかし、ディープラーニングのアルゴリズムに関して課題となっているのは、どのような根拠で判断を下したかがブラックボックスとなる点だ。ブラックボックスのままでは、誤認識が起きた時にその原因を特定するのが難しく、認識率を向上する道筋をつけにくく膨大な学習データが必要になる。ボッシュも、ディープラーニング以外に複数のアルゴリズムを組み合わせることで、信頼性と精度を確保している。

「ディープラーニングの学会に参加すると、大きく2つのAIに分かれている。1つは先述したように、ブラックボックスを透明化し、説明責任を果たせる『説明可能なAI』を重視するグループだ。彼らは、追加学習で必要な教師データが膨大になることも解決しようと取り組んでいる。総務省も、2018年11月に説明可能なAIの開発に関するガイドラインを公開する予定で、AIの説明責任を果たすことは今後さらに重要な開発テーマになる。もう1つは、人間が自分自身の判断の理由を説明できない場合があるように、脳の一部を模したディープニューラルネットワークにも間違いやバイアスがあることを受け入れる『人間らしいAI』を主張するグループだ。どちらが正しいというわけではないが、モノづくりに求められるのは説明可能なAIの方だろう」(猪貝氏)

猪貝氏は、ディープラーニングのブラックボックス解析技術として、教師データのどの部分を根拠にしたか、どの教師データが判断に影響を与えたかを分析する技術が複数登場し、進展していることを紹介した。こうした解析技術は、説明責任を果たすためだけでなく、誤判定が起きた要因を基に学習データを調整し、認識精度を向上させる上で役立つという。

実際のクルマの画像を基に、ディープラーニングによる推論の結果と、推論で着目したポイントを分析すると、クルマ全体を見ているわけではないことが分かる。タイヤとボンネットの一部、ピラーとフロントガラスといったピンポイントを認識して高い確信度で判断することもあれば、クルマの後ろに立っている木をクルマの一部と認識して確信度が下がったり、車両の大部分に着目しているにもかかわらず、判断に必要な特徴量が不足して確信度が低くなったりする場合もある。解析技術はこうした判断のプロセスを明らかにすることができる。これらを基にAIが見ていなかったポイントや、不足していた特徴量を補えるような学習データを追加すれば、効率的に追加学習を行うことができるとしている。

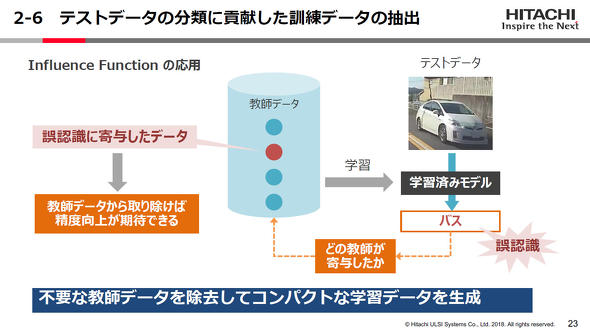

さらに、別のブラックボックス解析技術を用いると、「この画像はどの学習データのおかげ正しく分類したのか」を把握することもできるという。これを応用すれば、誤認識につながった学習データを取り除くことで精度を向上するとともに、重複するデータを排除して学習データが膨大になるのを抑え、追加学習を効率化することが期待できる。

関連記事

ボッシュが開発に取り組む“説明可能なAI”

ボッシュが開発に取り組む“説明可能なAI”

Robert Bosch(ボッシュ)が2017年1月にAIセンター(BCAI:Bosch Center for Artificial Intelligence)の稼働を発表してから半年が過ぎた。年次会見にAIセンターのグローバル責任者であるクリストフ・パイロ氏が出席、AIセンターの目的や取り組みについて語った。 市街地の自動運転で役割広がるAI、車載カメラでの使い方さまざま

市街地の自動運転で役割広がるAI、車載カメラでの使い方さまざま

「人とくるまのテクノロジー展2018」に出展した外資系大手サプライヤーのブースから、人工知能技術を活用した画像認識の取り組みを紹介する。 ディープラーニングで最適なステアリング制御は実現するか、スバルの挑戦

ディープラーニングで最適なステアリング制御は実現するか、スバルの挑戦

SUBARU(スバル)は、NVIDIAのユーザーイベント「GTC Japan 2018」(2018年9月13〜14日)において、2024年以降の製品化を目指す開発中の自動運転システムについて紹介した。スバル 第一技術本部 自動運転PGMの主査で、開発に携わる小山哉氏が登壇した。 自動運転の「判断」のデファクトを狙う、デンソーが半導体のIP設計で新会社

自動運転の「判断」のデファクトを狙う、デンソーが半導体のIP設計で新会社

デンソーは、自動運転システムの「判断」を担う半導体IPを設計する新会社を設立する。会社名は「エヌエスアイテクス(NSITEXE)」で、デンソーの完全子会社となる。資本金は1億円。売り上げ目標などは非公表。 デンソーがクルマに載せられるAIの開発に注力、「かなり早めに出せる」

デンソーがクルマに載せられるAIの開発に注力、「かなり早めに出せる」

デンソーが東京都内で報道陣向けにAI(人工知能)取材会を開催。自動運転やADAS(高度運転支援システム)向けでAIを実用化するために開発しているさまざまな技術を、デモンストレーションで披露した。

Copyright © ITmedia, Inc. All Rights Reserved.