グーグルの量子超越性を静観する富士通、実用性重視のAI技術で2つの「世界初」:人工知能ニュース(3/3 ページ)

AIの学習時間を10倍に高速化

もう1つの新AI技術であるContent-Aware Computingは、AIの学習プロセスを効率化するものだ。AIの活用に向けて計算需要は急激に拡大している。例えば、スーパーコンピュータ「京」の全系を用いた学習時間で比較すると、2012年に登場したAlexNetが50秒なのに対し、2018年の囲碁AI「Alpha Go Zero」は約6カ月かかるという。つまり、6年で30万倍になったことになる。

今後もAI学習のための計算需要は拡大する見込みだが、それらを扱うコンピューティングのためのスキルも高度化していく。例えば、富士通は2019年4月、ResNet-50を用いたディープラーニングの学習時間で世界最高速を達成したが、これはAIとコンピューティングの専門家が手作業でチューニングした結果であり、この高速化を実現した技術を一般ユーザーが簡単に使うことは難しい。

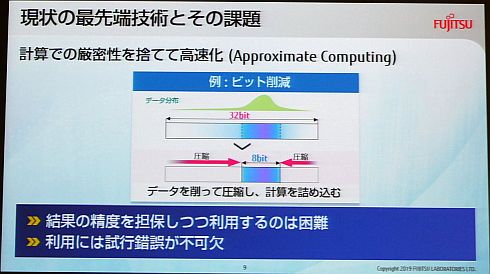

Content-Aware Computingは、AI学習の高速性と使いやすさの両立を目指して開発された技術である。AI学習における高速化では、機械学習の演算精度として一般的な32ビットから16ビットや8ビットに落とすビット削減という手法が注目されている。ただし、一律に演算精度を落とすと演算結果も劣化するため、演算精度の調整は、どの箇所の演算精度を落とし、どの箇所の演算精度を落とさないかを、専門家が試行錯誤する必要があった。

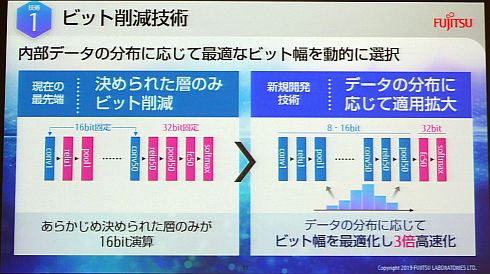

そこでContent-Aware Computingは、プログラム挙動を動的に分析することで、専門家が静的に行ってきた試行錯誤を自動化している。採用した技術は2つ。1つは、ビット削減について、内部データの分布に応じて最適なビット幅を動的に選択する技術だ。従来は、ニューラルネットワークのうち決められた層だけをビット削減して演算していたが、この技術では各層のテータの分布に応じてビット削減の適用を拡大できる。

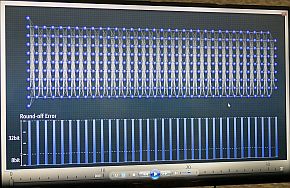

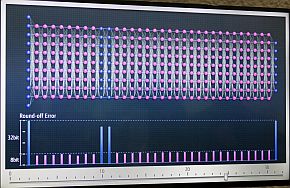

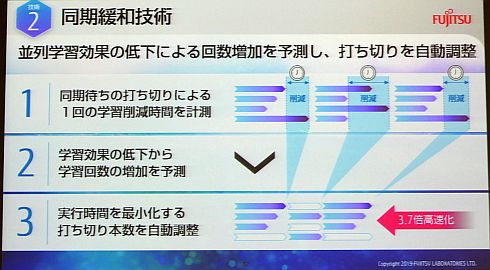

もう1つは、クラウドなど多数ノードで並列計算を行う環境で、通信の競合や割り込み処理などにより一部ノードでのレスポンスが大幅に遅れる同期待ちを緩和する技術である。同期待ちを打ち切った場合の処理時間の削減量と演算結果への影響度を予測し、演算結果を劣化させない範囲で、処理時間を最大限に削減できるように、各同期待ちの打ち切り時間を制御する。

2048ノードを使った並列計算での同期待ちの事例。最初は各ノードの計算時間はほぼ10msで推移するが(左)、一部のノードでリソース競合による性能劣化が起こる(中央)。並列計算では一番遅い処理を待って同期するので、一部のノードの後れが全体性能の劣化につながる。従来技術と新技術適用の比較イメージ(右)。早々に計算中断することで高層化を果たせる(クリックで拡大) 出典:富士通研究所

2048ノードを使った並列計算での同期待ちの事例。最初は各ノードの計算時間はほぼ10msで推移するが(左)、一部のノードでリソース競合による性能劣化が起こる(中央)。並列計算では一番遅い処理を待って同期するので、一部のノードの後れが全体性能の劣化につながる。従来技術と新技術適用の比較イメージ(右)。早々に計算中断することで高層化を果たせる(クリックで拡大) 出典:富士通研究所RestNet-50で約70GBの画像データを学習する事例では、ビット削減で従来比3倍、同期待ち緩和で同3.7倍の高速化を確認しており、最大10倍の高速化を実現できることになる。富士通はContent-Aware Computingについても「世界初」の技術としており、2020年度内に実用化する方針である。

関連記事

量子コンピュータとAI、先進技術における日本の最新動向と位置付け

量子コンピュータとAI、先進技術における日本の最新動向と位置付け

日本最大級の産学官連携イベント「イノベーション・ジャパン2019」(2019年8月29〜30日、東京ビッグサイト青海展示棟)において、科学技術振興機構(JST)事業セミナーで、JST研究開発戦略センター(CRDS)がAI技術および量子コンピュータ技術の最新動向について紹介した。 量子コンピューティングは製造業でも活用進む、その可能性と現実

量子コンピューティングは製造業でも活用進む、その可能性と現実

次世代のコンピューティング技術として注目を集める「量子コンピュータ」。製造業にとっての量子コンピュータの可能性について、ザイナス イノベーション事業部 部長で量子計算コンサルタントの畔上文昭氏に、製造業での量子コンピューティング技術の活用動向と現実について話を聞いた。 量子コンピュータって実際のところ何? NECもアニーリングに注力

量子コンピュータって実際のところ何? NECもアニーリングに注力

NECは2019年1月16日、報道陣を対象として量子コンピュータに関する勉強会を開催し、同社が注力する超伝導パラメトロン素子を活用した量子アニーリングマシンの特徴と優位性を訴求した。同社は同マシンについて2023年の実用化を目指す方針だ。 顧客のDX実現を全てサポート、富士通がデータ×AIを描く

顧客のDX実現を全てサポート、富士通がデータ×AIを描く

富士通は2019年5月14日、顧客のデジタルトランスフォーメーション(DX)実現をデータとAI(人工知能)活用で支援するプロセスとフレームワーク「Design the Trusted Future by Data × AI」を発表した。同プロセス・フレームワークを用いたサービス提供は2019年7月にグローバル展開を開始する予定だ。 HPCとAI性能を両立したポスト「京」のCPU、ウエハーが初公開

HPCとAI性能を両立したポスト「京」のCPU、ウエハーが初公開

富士通は2019年5月14日、同社のプライベートイベント「富士通フォーラム2019 東京」(2019年5月17日、東京国際フォーラム)の内覧会で、次世代スーパーコンピュータであるポスト「京」に搭載されるプロセッサ「A64FX」のウエハーが初公開された。 富士通が量子コンピュータ超える新AI技術、グラフ構造データへの深層学習適用も

富士通が量子コンピュータ超える新AI技術、グラフ構造データへの深層学習適用も

富士通研究所が人工知能(AI)技術の最新成果を発表。「量子コンピュータを実用性で超える新アーキテクチャを開発」と「人やモノのつながりを表すグラフデータから新たな知見を導く新技術『Deep Tensor』を開発」の2件である。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

製造マネジメントの記事ランキング

- コニカミノルタと富士フイルムBIが複合機の調達業務で合弁協議、トナーの提携も

- 中小製造業の2人に1人が「毎日FAX使う」、DXが進まない要因とは

- オリンパスの新CMOが担う「MSA」の役割とは、内向きではなく患者と向き合う

- 「スキルデータ」の活用が製造業にもたらすメリットとは 実践事例と注意点を解説

- 製造業DXで日本が欧州から学ぶべき点、学ばなくてもよい点は何か

- 品質管理に必須の統計的手法「X-R管理図」「P管理図」の作り方

- 見積もり時間をゼロに 部品の納期と金額を即時算定するミスミの新システム

- 新会社名は「ETRIA」 リコーと東芝テックの複合機開発/生産事業統合へ

- 生成AIが運用保守困難なシステムを解析 リバースエンジニアリングするサービス

- 試行フェーズを脱した通信業界の生成AI活用 MWC 2024レポート(後編)